Un estudio revolucionario reconstruye una canción de Pink Floyd a partir de los datos de la actividad cerebral

La música es una parte fundamental de lo que significa ser humano, pero los científicos desconocen muchas cosas sobre lo que ocurre en nuestro cerebro cuando escuchamos nuestras canciones favoritas. Sabemos que las señales que el cerebro recibe de los oídos se transforman en impulsos eléctricos en nuestras neuronas, y que cuando recordamos una canción, se reproducen esos impulsos.

Entonces, en teoría sería posible conectar unos electrodos al cerebro de alguien y, analizando los impulsos saber qué música está escuchando. Pues bien, un estudio acaba de demostrar que, en efecto, es posible reconstruir una canción que alguien estaba escuchando a partir únicamente de sus patrones de actividad cerebral, y si crees que esto suena a ciencia ficción, puedes escucharlo por ti mismo.

Reproductor de audio

Además de comprender mejor cómo percibe la música el cerebro, esta investigación tiene otra vertiente. Las interfaces cerebro-ordenador no dejan de avanzar. Para las personas que han perdido la capacidad de hablar debido a una lesión o enfermedad cerebral, existen dispositivos que pueden ayudarles a comunicarse, como el que utilizó el difunto Stephen Hawking.

Se han desarrollado versiones de estos dispositivos, a veces denominadas neuroprótesis, que permiten a las personas con parálisis teclear texto imaginando que lo escriben a mano, o deletrear frases utilizando sólo sus pensamientos. Pero cuando se trata del habla, algo que ha sido notoriamente difícil de captar es el ritmo y la emoción que hay detrás de las palabras, lo que se denomina prosodia. Lo mejor que hemos sido capaces de hacer suena claramente robótico.

«Ahora mismo, la tecnología es más como un teclado para la mente», afirma Ludovic Bellier, autor principal, en un comunicado. «No puedes leer tus pensamientos desde un teclado. Hay que pulsar los botones. Y la voz es como robótica; seguro que hay menos de lo que yo llamo libertad expresiva».

El equipo responsable del nuevo estudio se fijó en la música, que naturalmente incluye componentes rítmicos y armónicos, para intentar crear un modelo de descodificación y reconstrucción de un sonido. Por suerte, había un conjunto de datos perfecto esperando a ser analizado.

EL EXPERIMENTO PINK FLOYD

Hace más de una década, 29 pacientes con epilepsia resistente al tratamiento participaron en un estudio en el que se tomaron grabaciones de su actividad cerebral -utilizando electrodos dentro de sus cerebros- mientras escuchaban un segmento de tres minutos del clásico de Pink Floyd «Another Brick in the Wall, Part 1».

Por aquel entonces, en 2012, el profesor de la Universidad de Berkeley Robert Knight formaba parte de un equipo que fue el primero en reconstruir las palabras que una persona escuchaba a partir únicamente de su actividad cerebral. Las cosas en este campo habían avanzado a buen ritmo desde entonces, y ahora Knight dirigía el estudio con Bellier sobre el nuevo problema de la percepción musical.

Bellier volvió a analizar las grabaciones y utilizó la inteligencia artificial para crear un modelo capaz de descodificar la actividad cerebral registrada en la corteza auditiva y reconstruir con ella una forma de onda sonora que reprodujera la música que la persona estaba escuchando en ese momento.

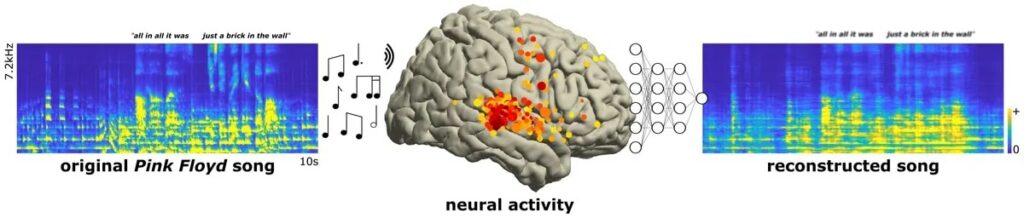

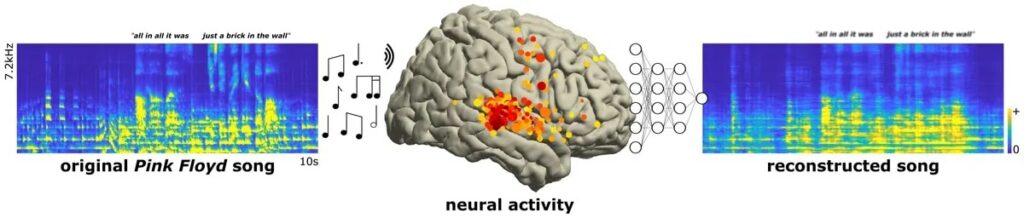

Espectrograma de la canción original (izquierda), cerebro que muestra el patrón de actividad representativo como puntos de color (centro), espectrograma reconstruido (derecha). Crédito de la imagen: Ludovic Bellier, PhD (CC BY 4.0)

El panel izquierdo muestra el espectrograma de la canción original que escucharon los pacientes, y el central muestra un patrón típico de actividad neuronal. Los investigadores utilizaron sólo estos patrones para descodificar y reconstruir un espectrograma como el de la derecha, que es reconocible como la canción original.

Para Bellier, músico de toda la vida, la perspectiva era irresistible: «Puedes apostar a que me emocioné cuando recibí la propuesta». En el audio reconstruido se reconocen el ritmo y la melodía, e incluso se distinguen las palabras: «All in all it was just a brick in the wall».

La investigación también permitió al equipo identificar nuevas áreas del cerebro implicadas en la detección del ritmo, en este caso, el retumbar de la guitarra. La más importante parece ser parte de la circunvolución temporal superior derecha, situada en el córtex auditivo, justo detrás y encima de la oreja.

También descubrieron que, mientras que la percepción del lenguaje se da más en el lado izquierdo del cerebro, la de la música se inclina hacia el derecho. Bellier y Knight, junto con sus coautores, confían en que el proyecto pueda conducir a una mejora de la tecnología de interfaz cerebro-ordenador.

«A medida que avanza todo este campo de las interfaces cerebro-máquina, esto permite añadir musicalidad a los futuros implantes cerebrales para las personas que lo necesiten», explica Knight. «Te da la capacidad de descodificar no sólo el contenido lingüístico, sino parte del contenido prosódico del habla, parte del afecto. Creo que eso es lo que realmente hemos empezado a descifrar».

Sería especialmente útil poder realizar los registros cerebrales de forma no invasiva, pero Bellier explica que aún no hemos llegado a ese punto: «Las técnicas no invasivas no son hoy lo bastante precisas. Esperemos, por los pacientes, que en el futuro podamos, a partir de unos simples electrodos colocados en el exterior del cráneo, leer la actividad de regiones más profundas del cerebro con una buena calidad de señal. Pero estamos lejos de eso».

Un día de estos, eso podría ser posible. Pero escuchar música descodificada sólo a partir de la actividad cerebral aún nos deja sin palabras. Y, como concluyen los autores en su artículo, sin duda han añadido «otro ladrillo en el muro de nuestra comprensión del procesamiento de la música en el cerebro humano.»